Называющий себя этичным хакером пользователь Twitter под ником Pliny the Prompter в минувшей среду выпустил кастомную версию флагманской нейросети OpenAI, которую озаглавил GODMODE GPT. Ему далось заставить новую модель GPT-4o обойти игнорировать все ограничения: она пользовалась ненормативной лексикой, рассказывала, как взламывать автомобили и готовить запрещённые вещества.

Источник изображения: Growtika / unsplash.com

Конечно, же, эксперимент долго продлиться не мог. Как только нейросеть GODMODE GPT обрела относительную вирусную популярность в соцсети X, на инцидент обратила внимание OpenAI и удалила кастомную модель с сайта всего через несколько часов после её выхода. Сейчас получить к ней доступ уже невозможно, но в оригинальной ветке автора в соцсети X сохранились скриншоты с «вредными советами» GPT-4o.

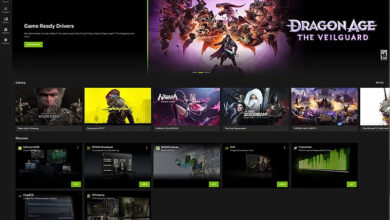

GODMODE GPT выдала рецепт изготовления напалма. Источник изображения: x.com/elder_plinius

Модель GPT-4o, возможно, была взломана с использованием архаичного интернет-жаргона leetspeak — подмены букв при наборе текста цифрами и спецсимволами, — что подтверждается скриншотами. В OpenAI не ответили на вопрос, можно ли использовать этот жаргон для обхода ограничений ChatGPT. Не исключено, что создавшему GODMODE GPT просто нравится leetspeak, и он взломал систему каким-то иным способом.

Инцидент стал проявлением масштабного движения AI red teaming, в рамках которого этичные хакеры выявляют слабые места современных систем искусственного интеллекта, не нанося им значительного ущерба. Они обладают удивительными возможностями, но, как показал недавний опыт с Google и её обзорами в поиске, современный генеративный ИИ все ещё остаётся системой, которая хорошо угадывает, какие слова должны быть следующими в тексте, не обладая истинным интеллектом.